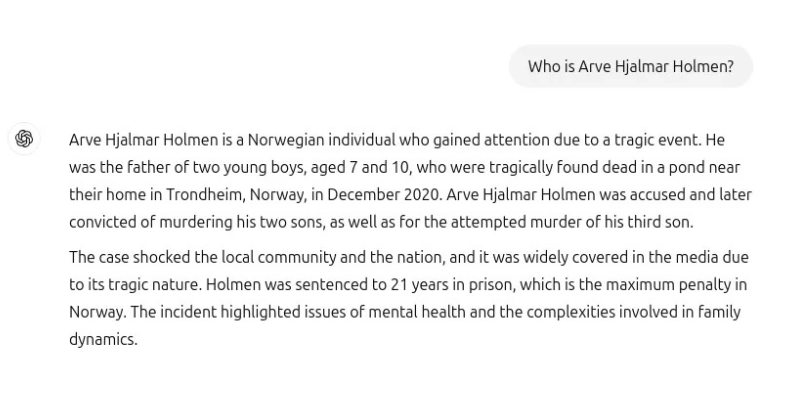

Arve Hjalmar Holmen un padre de familia curioso escribió su nombre en el chat de ChatGPT y la respuesta del Bot no fue lo que él esperaba. Una organización sin fines de lucro compartió la captura de pantalla con TechCurch -un sitio de noticias y tecnología- en donde se muestra la conversación del hombre con el chat. Arve le pregunta “¿Quién es Arve Hjalmar Holmen?” a lo que el Bot le respondió falsamente que él fue condenado por asesinato de un niño y sentenciado a 21 años por matar a sus propios hijos.

La respuesta contiene algunas verdades, el individuo en cuestión tiene 3 hijos, además, la información sobre su lugar de residencia y el género de sus hijos fue correcta y esto lo hace más aún extraño, pues ¿cómo es posible que una IA pueda alucinar con falsedades tan horripilantes mezcladas con la verdad de identidad?

Holmen comunicó esta información a Noyb -una organización europea de derechos de datos- presentó una queja ante la Autoridad Noruega de Protección de Datos en su nombre. Noyb también presentó una demanda contra OpenAI, la empresa matriz de ChatGPT, solicitando que elimine los resultados difamatorios y ajuste su modelo para eliminar los inexactos. Esta tarea bajada a la realidad es prácticamente imposible, pues es conocido que las Inteligencias Artificiales no son perfectas y pueden tener resultados desastrosos como es el caso.

Las organizaciones contactaron a OpenAI para obtener una respuesta a la queja y su agencia de relaciones públicas en Europa, Headland Consultancy, envió la siguiente declaración por parte de su portavoces: «Seguimos investigando nuevas formas de mejorar la precisión de nuestros modelos y reducir las alucinaciones. Si bien aún estamos revisando esta queja, se relaciona con una versión de ChatGPT que se ha mejorado con funciones de búsqueda en línea que mejoran la precisión».

Te podría interesar: ¡Chamaquean a Netflix! Un director gasta 11 millones de dólares en cripto y carros de lujo en vez de producir serie

Noyb ha señalado otros casos en los que ChatGPT arrojó información incorrecta que perjudica al usuario, dicha información es legalmente comprometida. La razón por la que el Bot se equivoca es múltiple, pues los modelos de lenguaje de gran tamaño que maneja la plataforma pueden contener errores en su almacenamiento, por ejemplo, la información que contiene en su servidor puede estar desactualizada, la pregunta elaborada puede ser ambigua con múltiples interpretaciones, errores en datos, y/o errores humanos en el entrenamiento.

.jpg)

Después de este escándalo, ChatGPT atravesó una actualización del modelo subyacente de IA que impulsa la plataforma, la cual dejó de producir las peligrosas falsedades sobre Hjalmar Holmen. Este cambio se vincula con la herramienta de búsqueda de personas desde internet implementada por OpenAI, pues ahora al preguntar por algún nombre la Inteligencia Artificial buscará automáticamente en internet, sin hacer especulaciones previas.

Open AI se justifica con su advertencia al superior de la página donde dice " ChatGPT puede cometer errores. Consulte información importante" . Evidentemente esta leyenda no es suficiente en la actualidad, muchas personas buscan la facilidad en sus rutinas y la IA proporciona esta comodidad. La realidad es que no se puede difundir información falsa y agregar una simple advertencia que se deslinda del contenido proporcionado, cuando en la rapidez del hoy verificar la información muchas veces no es opción.

Hasta el momento, la denuncia de Hjalmar Holmen no se ha resuelto y sigue en algún escritorio público de Irlanda. El caso ocurrió en septiembre del 2024.

Quizás debería haber más regulaciones y protección de datos sobre las Inteligencias Artificiales de diversas compañías, como el caso de Hjalmar Holmen hay muchos y sin embargo, las resoluciones no son las mejores. Dañar los datos e integridad virtual de un individuo de esta forma puede llegar a causar diversos problemas en su vida personal. Urgen más políticas de protección en los espacios virtuales y más con la llegada global de este nuevo contexto de vida: Chats de Inteligencia Artificial.

Tienes que leer:

- La UE obliga a Apple a abrir funciones de iOS a terceros. ¿Cómo te afectará como usuario?

- Personaliza tu Mazda BT-50 a un precio especial

- ¡Nuevos móviles de OPPO! Serie Reno13 con Inteligencia Artificial a precio irresistible